Kubernetes Descomplicado: Entenda Sua Arquitetura e Potencial

O que é Kubernetes e quais problemas ele resolve

Kubernetes (ou K8s) é uma plataforma open‑source para orquestração de contêineres, criada pelo Google e hoje mantida pela Cloud Native Computing Foundation (CNCF). Ela automatiza a implantação, o dimensionamento e o gerenciamento de aplicações em contêineres, respondendo à necessidade de coordenar ambientes Docker cada vez mais complexos.

Antes do Kubernetes, desenvolvedores e equipes de operação precisavam lidar manualmente com:

- Execução e replicação de contêineres;

- Balanceamento de carga;

- Descoberta de serviços;

- Atualizações sem downtime;

- Recuperação automática de falhas.

Kubernetes elimina essas dores ao oferecer:

- Automação total da implantação e do ciclo de vida das aplicações;

- Escala automática baseada na demanda;

- Alta disponibilidade e autocura (self‑healing);

- Modelo declarativo, onde o estado desejado é especificado e o sistema trabalha para alcançá‑lo;

- Gestão simplificada de rede e armazenamento para contêineres.

Em resumo, a plataforma traz robustez e escalabilidade, facilitando o trabalho de DevOps, desenvolvedores e administradores.

Cluster, Control Plane e Nodes

Cluster

Um cluster agrupa um ou mais nós (nodes) que executam aplicações containerizadas sob a administração do Kubernetes. O conjunto contém um control plane, que mantém o estado global, e os nodes, onde os workloads realmente rodam. Essa arquitetura distribuída permite execução coordenada, em larga escala e tolerante a falhas.

Control Plane (Plano de Controle)

O control plane funciona como o cérebro do conjunto. Ele toma decisões globais – como agendamento, resposta a eventos e manutenção do estado desejado – e expõe uma API que usuários e ferramentas utilizam para interagir com o sistema. Normalmente roda em máquinas separadas (master nodes), isolando as funções de administração das de execução.

Nodes

Os nodes são servidores físicos ou virtuais que fornecem CPU, memória, armazenamento e rede para os pods – a menor unidade de execução no Kubernetes. Existem dois tipos de nodes:

- Master node: hospeda o control plane (em clusters pequenos pode também executar workloads);

- Worker node: executa os pods que contêm as aplicações reais.

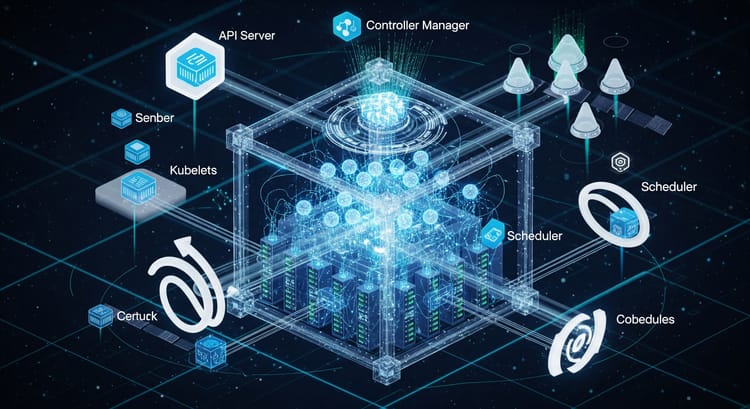

Principais Componentes do Kubernetes

API Server

O kube‑apiserver é a porta de entrada de todas as operações no conjunto. Ele oferece uma API REST que serve de interface para usuários (kubectl), componentes internos e ferramentas de automação. Suas funções principais são:

- Validar e processar requisições REST;

- Persistir o estado desejado no etcd;

- Notificar os demais componentes sobre mudanças.

Exemplo: kubectl get pods consulta o API Server para listar os pods ativos.

Scheduler (Agendador)

O kube‑scheduler decide em qual node cada novo pod será colocado. Ele avalia recursos disponíveis, afinidades, tolerâncias e outras restrições, escolhendo o node que melhor equilibra carga e eficiência.

Controller Manager

O kube‑controller‑manager roda um conjunto de controladores que mantêm o estado atual alinhado ao desejado. Entre eles:

- Replication Controller – garante o número especificado de réplicas;

- Node Controller – monitora a saúde dos nodes e reage a falhas;

- Endpoint Controller – atualiza os endpoints dos serviços;

- Service Account Controller – gerencia contas de serviço.

etcd

O etcd é um banco de dados chave‑valor distribuído e altamente disponível, onde o Kubernetes armazena toda a configuração e o estado do conjunto. Ele representa a source of truth e é replicado em múltiplas máquinas para garantir alta disponibilidade e integridade dos dados.

Kubelet

O kubelet é o agente que roda em cada node. Ele recebe a especificação dos pods do API Server, garante que os containers correspondentes estejam em execução e reporta o status de volta ao control plane. Na prática, o kubelet puxa imagens, inicia containers e monitora sua saúde.

Kube‑proxy

O kube‑proxy cuida da rede dentro do conjunto. Ele cria regras de proxy (iptables ou IPVS) que implementam balanceamento de carga e permitem a comunicação entre pods e serviços, tanto interno quanto externo ao agrupamento.

Fluxo de operação – Exemplo prático

- O usuário cria um manifesto YAML definindo um Deployment com 3 réplicas.

kubectl apply -f app.yamlenvia o manifesto ao API Server.- O API Server grava o estado desejado no etcd.

- O Scheduler identifica nodes com recursos disponíveis e agenda os pods.

- O Controller Manager detecta que os pods ainda não existem e aciona a criação.

- O kubelet em cada node designado puxa a imagem, inicia os containers e monitora seu estado.

- O kube‑proxy configura regras de balanceamento para que o serviço exposto pelos pods seja acessível.

Quando usar Kubernetes?

- Ambientes com múltiplas aplicações containerizadas e dependências complexas;

- Necessidade de automatizar escalonamento, atualizações sem downtime e recuperação automática;

- Requisitos de alta disponibilidade e resiliência;

- Desejo de balanceamento eficiente entre servidores e isolamento de workloads;

- Necessidade de gerenciamento integrado de rede e armazenamento;

- Equipes que adotam práticas DevOps e infraestrutura como código.

Esta visão geral fornece a base para entender a arquitetura e os componentes essenciais do Kubernetes. Nas próximas aulas, aprofundaremos a criação e administração de clusters, otimizações de configuração e boas práticas de orquestração de contêineres.